PaLM, l'IA de Google qui comprend les blagues

PaLM, c'est quoi ?

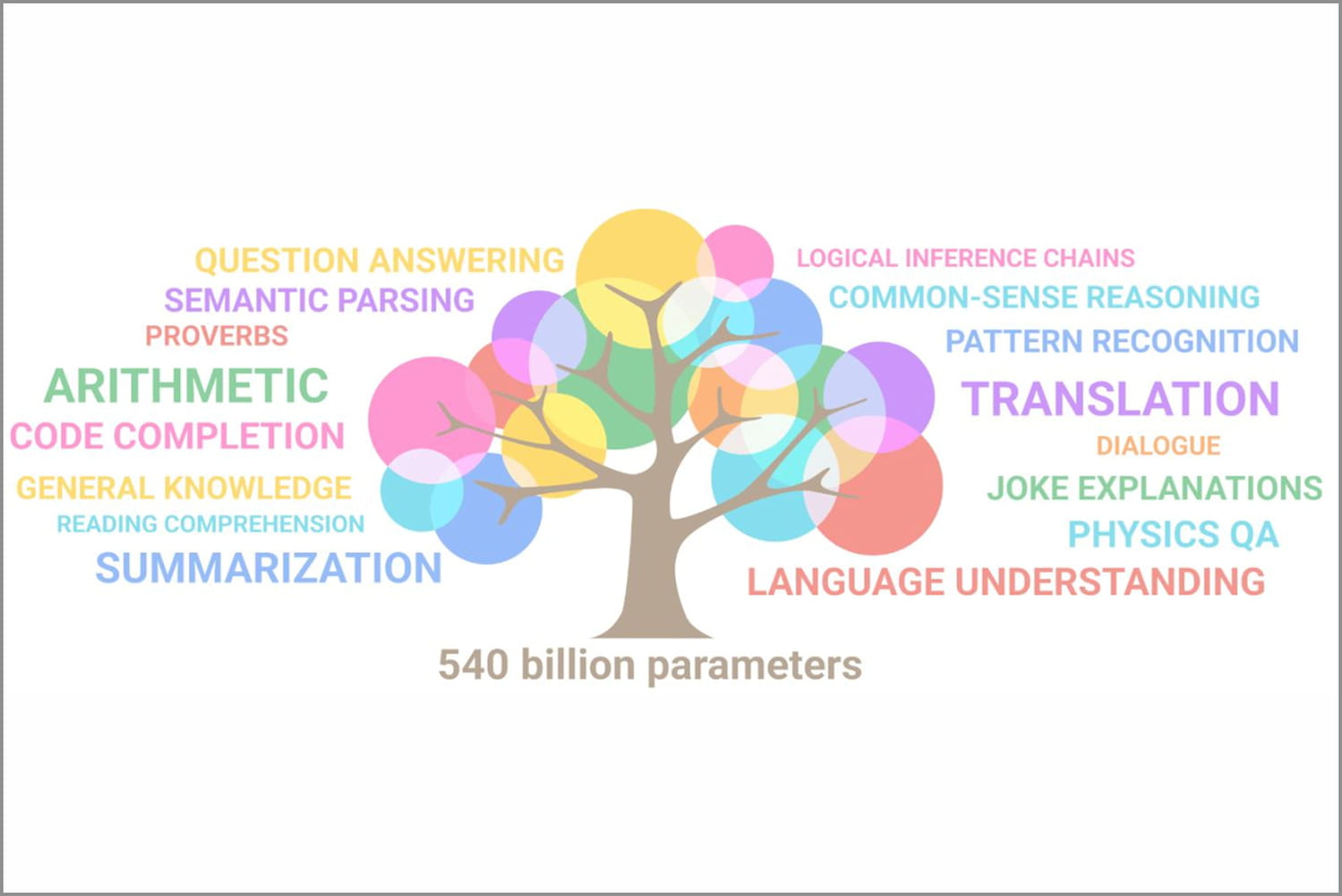

Développé par Google, Pathways Language Model (PaLM) est un réseau de neurones artificiels orienté traitement automatique du langage. Une IA de type Transformer qui compte à 540 milliards de paramètres.

PaLM suit les traces de GPT-3, le modèle de langue d'OpenAI. Avec ses 175 milliards de paramètres, ce modèle de deep learning, également de type Transformer, a été entraîné sur des centaines de milliards de mots. Comme GPT-3, PaLM affiche de nombreux cas d'usage, de la génération automatique de texte à la traduction en passant par la génération de codes informatiques.

Comment fonctionne PaLM ?

A l'instar de GPT-3, PaLM fait appel à la technique du few-shot learning. Comment ça marche ? Dans le cas de la reconnaissance d'image, ce type d'apprentissage ne disposera que de quelques photos du sujet à identifier (un visage par exemple) pour le réidentifier ensuite. Au lieu de s'entrainer à classer à partir de grandes séries d'exemples, le few-shot learning utilise ainsi quelques patterns de référence à partir desquels il calcule un score de similarité.

Plusieurs méga réseaux de neurones se sont depuis inspirés de GPT-3 et de la méthode du few-shot learning en vue d'améliorer encore les performances obtenues. C'est le cas de GLaM, LaMDA et Gopher, tous trois également créés par Google, ou encore de Megatron-Turing NLG qui, lui, a été développé par Microsoft et Nvidia.

Quelle est la performance de PaLM ?

Google a passé PaLM à la moulinette de son benchmark BIG-bench (pour Beyond the Imitation Game Benchmark). Un framework disponible en open source qui passe au crible les 150 tâches de modélisation du langage. "Résultat : PaLM surperforme majoritairement Gopher et Chinchilla sur un ensemble de 58 tâches communes", constatent Sharan Narang et Aakanksha Chowdhery chez Google Research (voir graphiques ci-dessous).

Parmi les actions mises en avant par Google, PaLM tire notamment son épingle du jeu en matière de gestion automatique de code applicatif, et en particulier de génération de code à partir de requêtes formulées en langage naturel. "Dans ce domaine, ses performances en few-shot learning sont comparables à celles de Codex (une déclinaison de GPT-3 centrée sur les mêmes types de tâches, ndlr) alors que son dataset d'apprentissage contient 50 fois moins de contenu en langage Python", soulignent Sharan Narang et Aakanksha Chowdhery. "Ce résultat renforce les conclusions antérieures selon lesquelles les grands modèles peuvent être plus efficaces que les plus petits, car leur transfère d'apprentissage en provenance d'autres langages […] est meilleur."

Les deux ingénieurs logiciels de Google ajoutent : "PaLM démontre par ailleurs des capacités impressionnantes de compréhension et de génération du langage naturel. Il peut notamment fournir des explications pour des scénarios qui nécessitent une combinaison complexe d'inférence logique en plusieurs étapes, de connaissances du monde et du langage. Par exemple, il est capable d'expliquer des blagues inédites." (voir gif ci-dessous)

Comment PaLM a-t-il été entrainé ?

PaLM a été entrainé sur une infrastructure Tensor Processing Unit (TPU) de Google. Composée de 6 144 puces, elle s'adosse à la dernière génération des pods TPU du cloud américain, avec à la clés des processus de parallélisassion de données mis en œuvre au sein de chaque pod.

L'apprentissage a été réalisé sur une série de data sets multilingues combinant des documents et livres disponibles en ligne, des conversations, des contenus Wikipedia et du code source disponible sur GitHub.